機械と話す未来「第5回 会話する機械の今後」

東北大学

2016/10/07 10:11

第5回 会話する機械の今後

現在は主にスマホのアプリやカーナビなどで音声による入力が使われていますが、音声、あるいはもっと広く「言葉で対話する」機械は今後どうなっていくでしょうか。未来予知はいつも難しいものですが、外れるのを覚悟の上で、少し未来について考えてみたいと思います。

一つの可能性はロボットです。いま、ソフトバンクのPepperやシャープのロボホンなど、ロボットが職場や家庭に少しずつ入ってきています。これらのロボットは、従来工場で利用されてきた産業用ロボットとは違い、人間とコミュニケーションすることを主目的としたロボット(コミュニケーションロボット)です。

コミュニケーションロボットは人間に似た形をしていることが多いので、利用者は当然会話ができるものだという偏見を持って接します。Pepperにはタブレットがついていますが、Pepperとやりとりをするときにまずタブレットをさわるという人はまれでしょう。

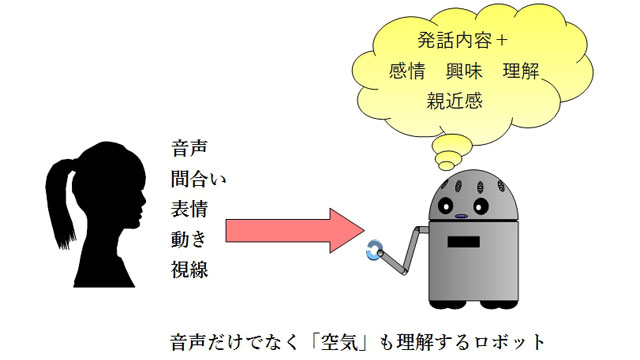

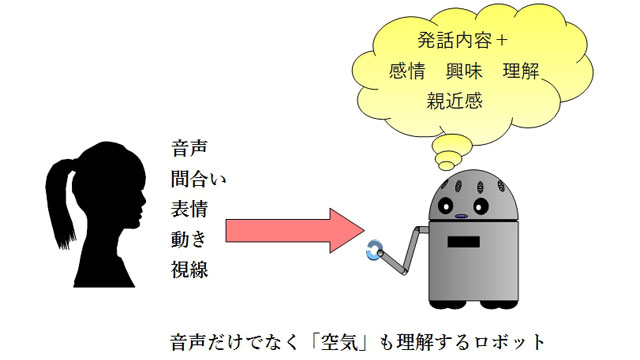

ロボットとのコミュニケーションは音声が主体となるでしょうが、実際には必要な用事を音声でやりとりするだけでなく、相手が人間だったならば当然期待するような微妙なやりとりも利用者はロボットに対して期待するでしょう。

これはたとえば、利用者は喜んでいるのか怒っているのか、興味があるのかないのか、ロボットと人間は親しいのか親しくないのかなど、人間同士がコミュニケーションを取るときに必要なあらゆる関係性が含まれます。こういうことを理解しながら会話をするためには、単に音声を認識するだけではなくて、声の調子や表情、視線、体の動きなどを見ながら相手の様子を観察しなければなりません。

音声の認識性能や合成音声の品質は今後ますます向上すると思いますが、それらの性能が上がれば上がるほど、これら微妙な関係を読む能力の欠如(いわゆる「空気の読めなさ」)が問題になってくると思います。これは、コンピュータグラフィックスのキャラクタが人間そっくりになればなるほど見た目が気持ち悪くなる現象、いわゆる「不気味の谷」と同じような現象なのかもしれません。このような感情や雰囲気を読む研究は近年盛んになってきていますが、まだまだ不十分です。

もう一つの可能性としてスマートホームがあります。スマートホームは、コンピュータによって家のあらゆるところがコントロールできるようにし、またセンサを多数配置して、それらをネットワークでつなぐというものです。スマートホームに関連した音声技術として、Amazonが発表しているEchoのように、家庭で行われる会話を全部認識して、それに合わせたサービスを提供するというアイデアもあります。

また、スマートホームの環境で、声で指示するとその通りに家の環境がコントロールできるというアイデアも以前からあります。これらのアイデアと、近年盛んな「モノのインターネット(IoT)」との組み合わせで、家全体が言葉を理解するという環境が近い将来に実現するかもしれません。

【プロフィール】

伊藤 彰則(いとう あきのり)

東北大学大学院工学研究科通信工学専攻教授

ホームページはこちらから

1993年東北大学工学研究科博士課程修了。2010年より現職。音声認識、音声合成、音声対話、音楽情報処理、マルチメディア通信など、声と音を中心に、さまざまなメディアを使った人間と機械のコミュニケーションの研究をしている。

現在は主にスマホのアプリやカーナビなどで音声による入力が使われていますが、音声、あるいはもっと広く「言葉で対話する」機械は今後どうなっていくでしょうか。未来予知はいつも難しいものですが、外れるのを覚悟の上で、少し未来について考えてみたいと思います。

一つの可能性はロボットです。いま、ソフトバンクのPepperやシャープのロボホンなど、ロボットが職場や家庭に少しずつ入ってきています。これらのロボットは、従来工場で利用されてきた産業用ロボットとは違い、人間とコミュニケーションすることを主目的としたロボット(コミュニケーションロボット)です。

コミュニケーションロボットは人間に似た形をしていることが多いので、利用者は当然会話ができるものだという偏見を持って接します。Pepperにはタブレットがついていますが、Pepperとやりとりをするときにまずタブレットをさわるという人はまれでしょう。

ロボットとのコミュニケーションは音声が主体となるでしょうが、実際には必要な用事を音声でやりとりするだけでなく、相手が人間だったならば当然期待するような微妙なやりとりも利用者はロボットに対して期待するでしょう。

これはたとえば、利用者は喜んでいるのか怒っているのか、興味があるのかないのか、ロボットと人間は親しいのか親しくないのかなど、人間同士がコミュニケーションを取るときに必要なあらゆる関係性が含まれます。こういうことを理解しながら会話をするためには、単に音声を認識するだけではなくて、声の調子や表情、視線、体の動きなどを見ながら相手の様子を観察しなければなりません。

音声の認識性能や合成音声の品質は今後ますます向上すると思いますが、それらの性能が上がれば上がるほど、これら微妙な関係を読む能力の欠如(いわゆる「空気の読めなさ」)が問題になってくると思います。これは、コンピュータグラフィックスのキャラクタが人間そっくりになればなるほど見た目が気持ち悪くなる現象、いわゆる「不気味の谷」と同じような現象なのかもしれません。このような感情や雰囲気を読む研究は近年盛んになってきていますが、まだまだ不十分です。

もう一つの可能性としてスマートホームがあります。スマートホームは、コンピュータによって家のあらゆるところがコントロールできるようにし、またセンサを多数配置して、それらをネットワークでつなぐというものです。スマートホームに関連した音声技術として、Amazonが発表しているEchoのように、家庭で行われる会話を全部認識して、それに合わせたサービスを提供するというアイデアもあります。

また、スマートホームの環境で、声で指示するとその通りに家の環境がコントロールできるというアイデアも以前からあります。これらのアイデアと、近年盛んな「モノのインターネット(IoT)」との組み合わせで、家全体が言葉を理解するという環境が近い将来に実現するかもしれません。

【プロフィール】

伊藤 彰則(いとう あきのり)

東北大学大学院工学研究科通信工学専攻教授

ホームページはこちらから

1993年東北大学工学研究科博士課程修了。2010年より現職。音声認識、音声合成、音声対話、音楽情報処理、マルチメディア通信など、声と音を中心に、さまざまなメディアを使った人間と機械のコミュニケーションの研究をしている。